V posledních dnech jste možná na svém WhatsApp nebo Instagramu obdrželi podivná videa. Například video, kde tygr odnáší spícího člověka, leopard procházející ulicemi Lucknow, nebo videa, kde se leopardi dostávají do domů v Puné. Někdy narazíte na záznam, na kterém sedí tygr a je krmen člověkem alkoholem. Po zhlédnutí takovýchto videí jste možná byli zaskočeni, vyděšeni, nebo jste je ihned posílali dál. Zastavte se však. Všechna tato videa jsou falešná. Nejsou natočena pravým fotoaparátem, ale byla generována umělou inteligencí.

Sociální média nyní plní videa vytvořená AI tak realisticky, že se jimi běžní lidé snadno dají oklamat. V posledních šesti měsících došlo k výrazným vylepšením aplikací pro generování videí, jako jsou Sora, Kling, Luma. Dnes stačí napsat jedno jednoduché větu a během několika sekund se vytvoří video, které vypadá naprosto autenticky. V důsledku toho se nyní šíří falešné videa s tygři, leopardy, medvědy a dalšími zvířaty.

Jak rozpoznat falešná videa AI

Pokud se domníváte, že kvalita videa je velmi špatná, pak na něj ihned nevěřte. I průměrný mobilní telefon dokáže natočit jasné video ve 4K kvalitě, takže si zeptejte sami sebe, proč je toto video rozmazané. Často se stává, že videa generovaná AI mají nízkou kvalitu.

1. Falešné CCTV záznamy

Aby skryla podvod, jsou videa prezentována ve formě CCTV záznamů. Místo data a času jsou na obrazovce pouze čísla a zvuk není nikdy dobře slyšet.

2. Přehnaná dokonalost

Pokud je například pleť až příliš lesklá, oči a nos vypadají naprosto dokonale, nebo jsou vlasy a oblečení nepřirozeně se hýbající, existuje vysoká pravděpodobnost, že se jedná o video generované AI. Emoce v očích, detaily obličeje, to AI zatím nedokáže reprodukovat důvtipně.

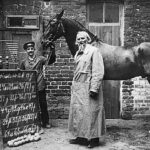

3. Kontrola rukou a fyziky

Umělá inteligence má stále potíže s realistickým zobrazením rukou a prstů. Když někdo skáče nebo běží, často se objevují problémy se stíny, osvětlením a proporcemi těla.

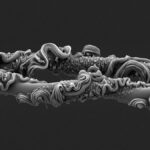

4. Zmizelé nebo měnící se detaily

Vzpomínáte na video králíka skákajícího na trampolíně? V něm se náhle jeden králík kompletně vymaže a jiný mění tvar. Takovéto detaily si člověk může snadno všimnout.

5. Krátká délka videí

Celá videa obvykle vyžadují platby. To znamená, že většina virálních videí vytvořených zdarma umělou inteligencí trvá pouze několik sekund.

6. Vodotisk Sory

Video vytvořené Sora, technologií od OpenAI, má na sobě vodotisk slova „Sora“. Ten může být blokován nebo rozmazán.

7. Je to vůbec možné?

Je opravdu možné, aby tygr seděl u silnice a byl krmen alkoholem člověkem? Když si tuto otázku položíte, 90% falešných videí lze okamžitě rozpoznat.

Případ s videem opilého tygra vedl k tomu, že policie v Nagpuru poslala varování osobě, která šířila drby. Také videa leoparda v Puné byla vyhlášena za falešná ministerstvem životního prostředí. Umělá inteligence se den za dnem zdokonaluje. V budoucnu mohou tato videa vypadat ještě realističtěji. Proto bychom si měli zvyknout být obezřetní a než video poskytneme dál, měli bychom se několik sekund zastavit, zkontrolovat výše uvedené body a až poté sdílet. Jinak se sami nechtěně účastníme šíření falešných a strašidelných informací.